Vorarbeitungsprozess automatisiert mit Python

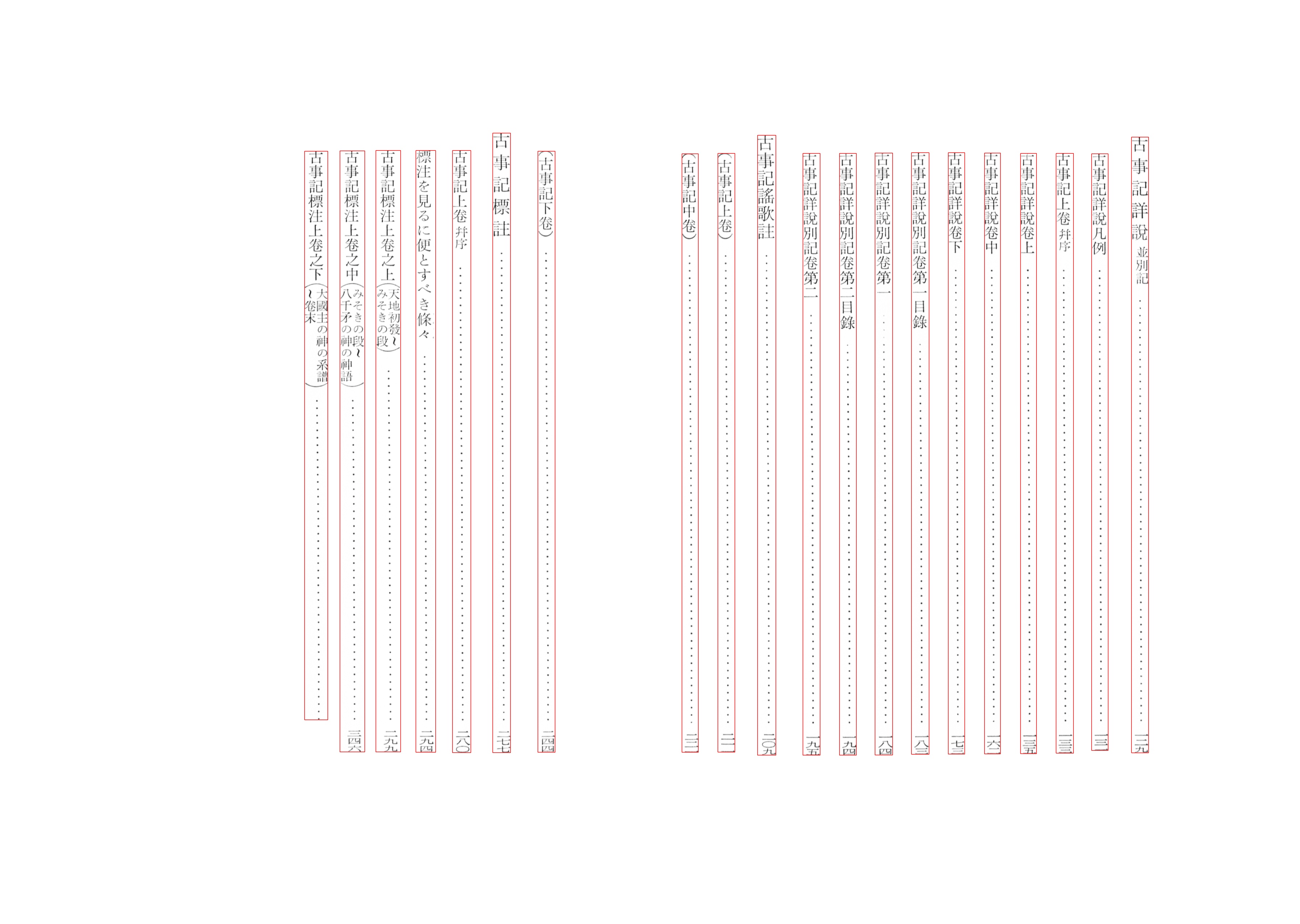

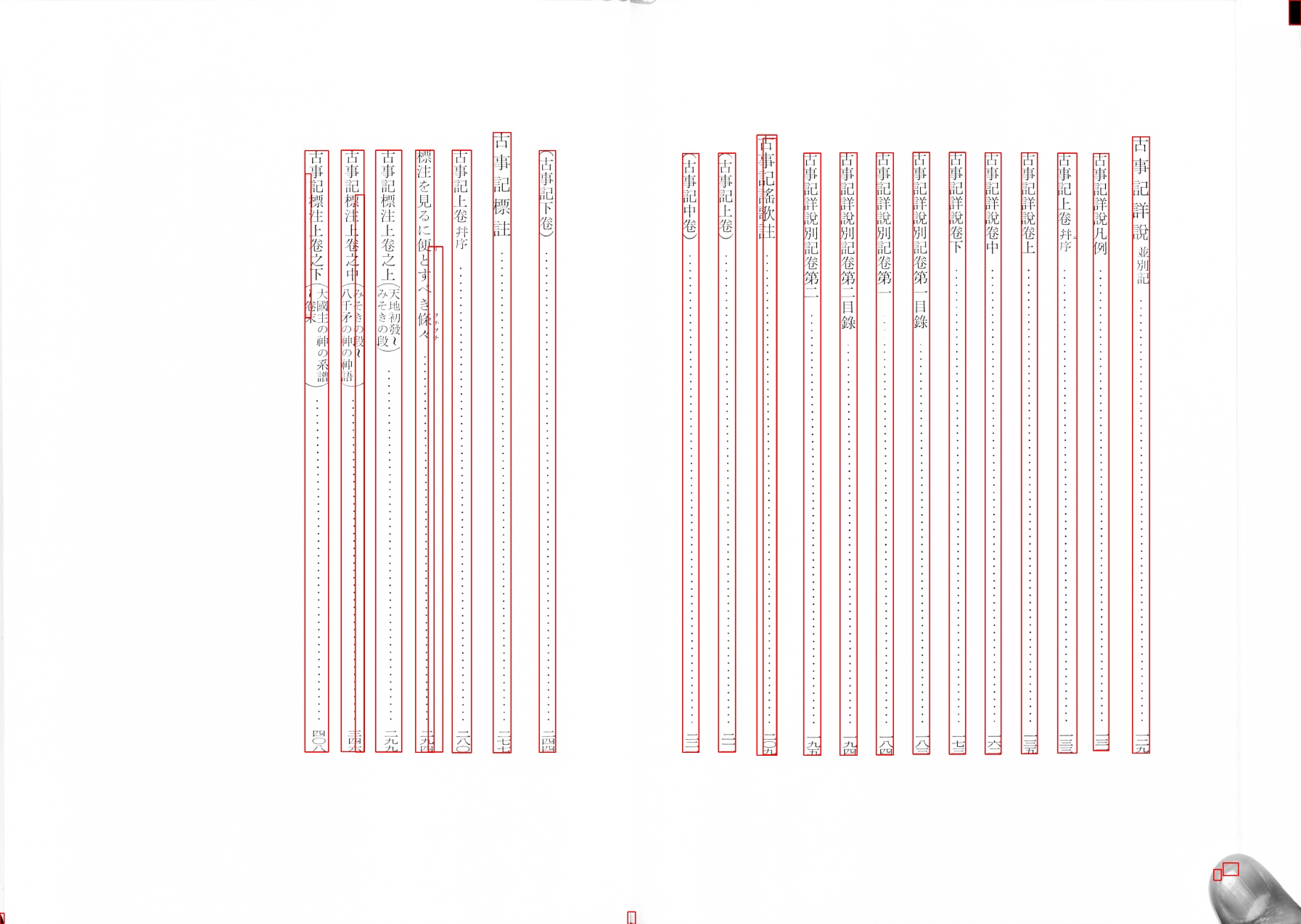

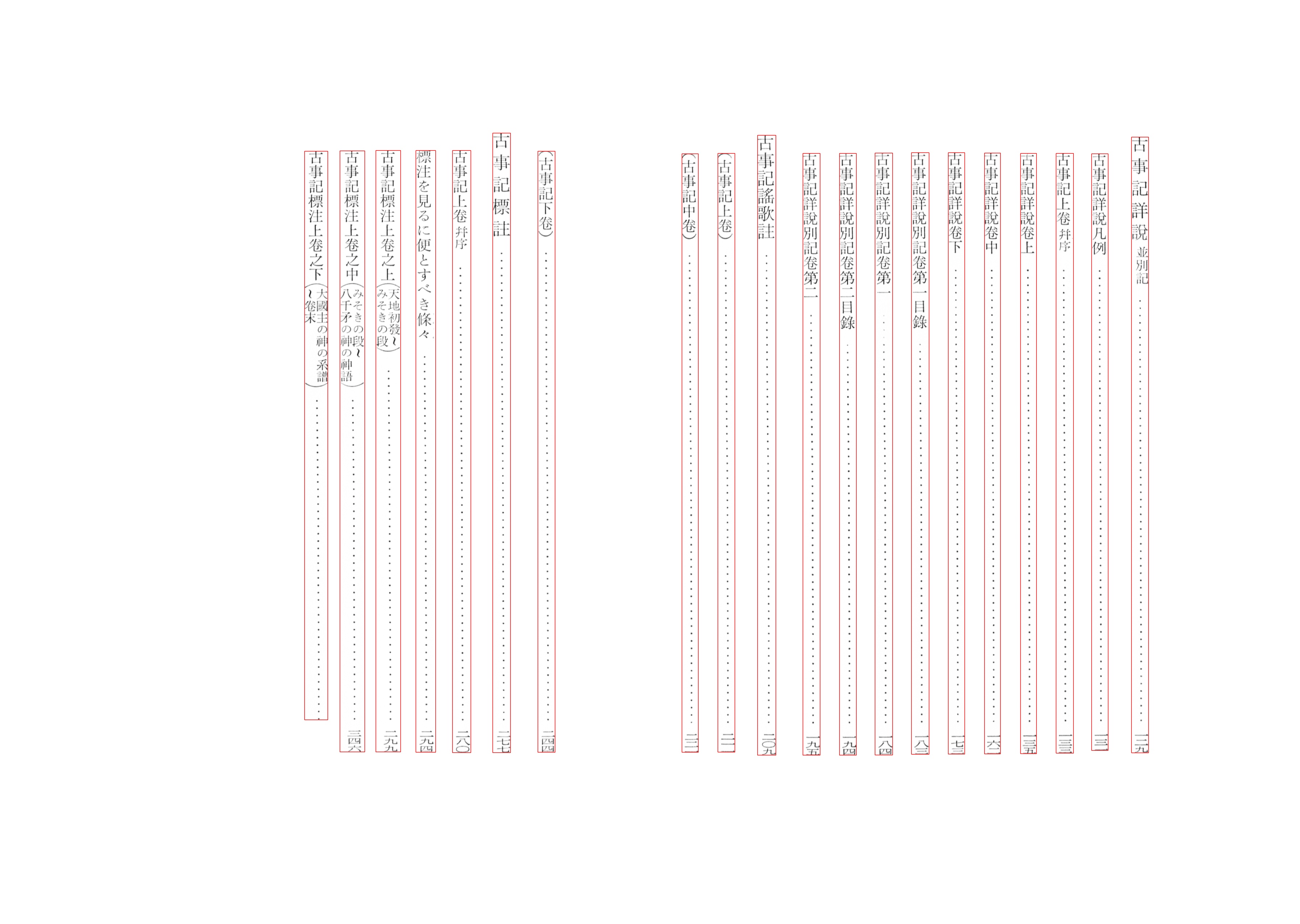

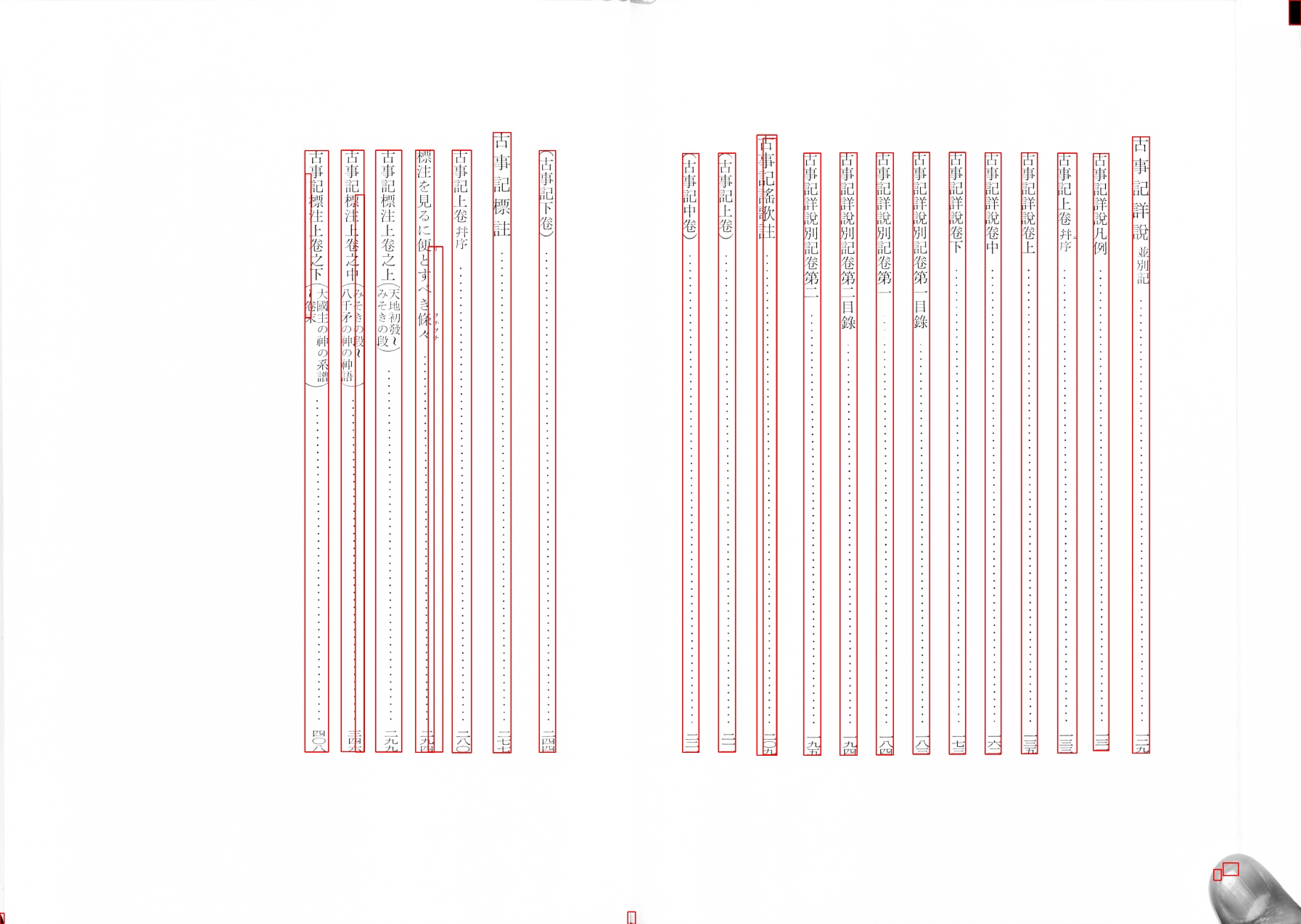

Zuerst Textbereich markieren...

Danach den Aussenbereich mit der weissen Farben füllen

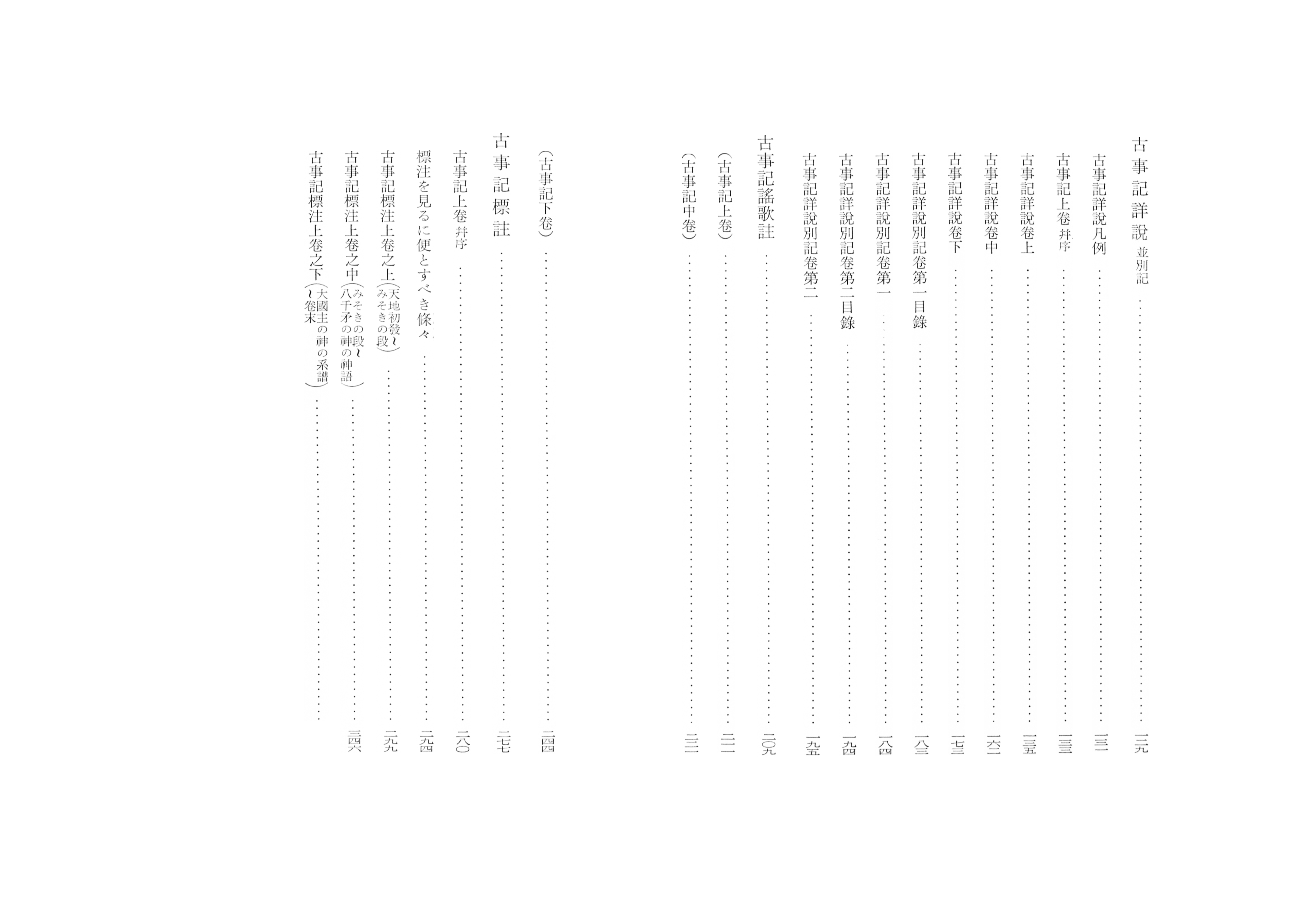

1. Datenset

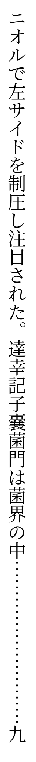

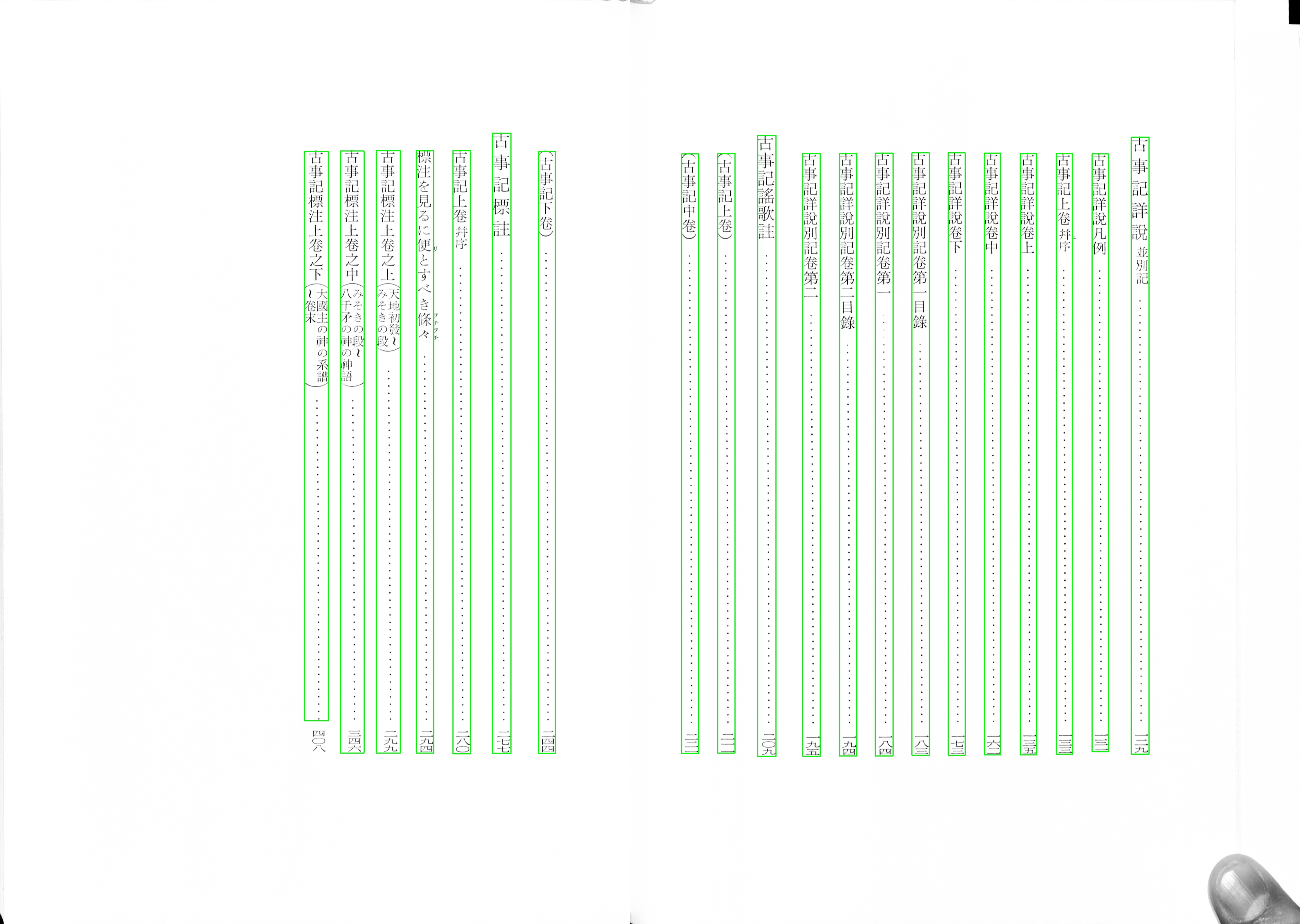

2. Datenset

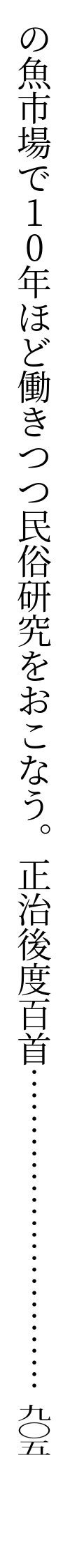

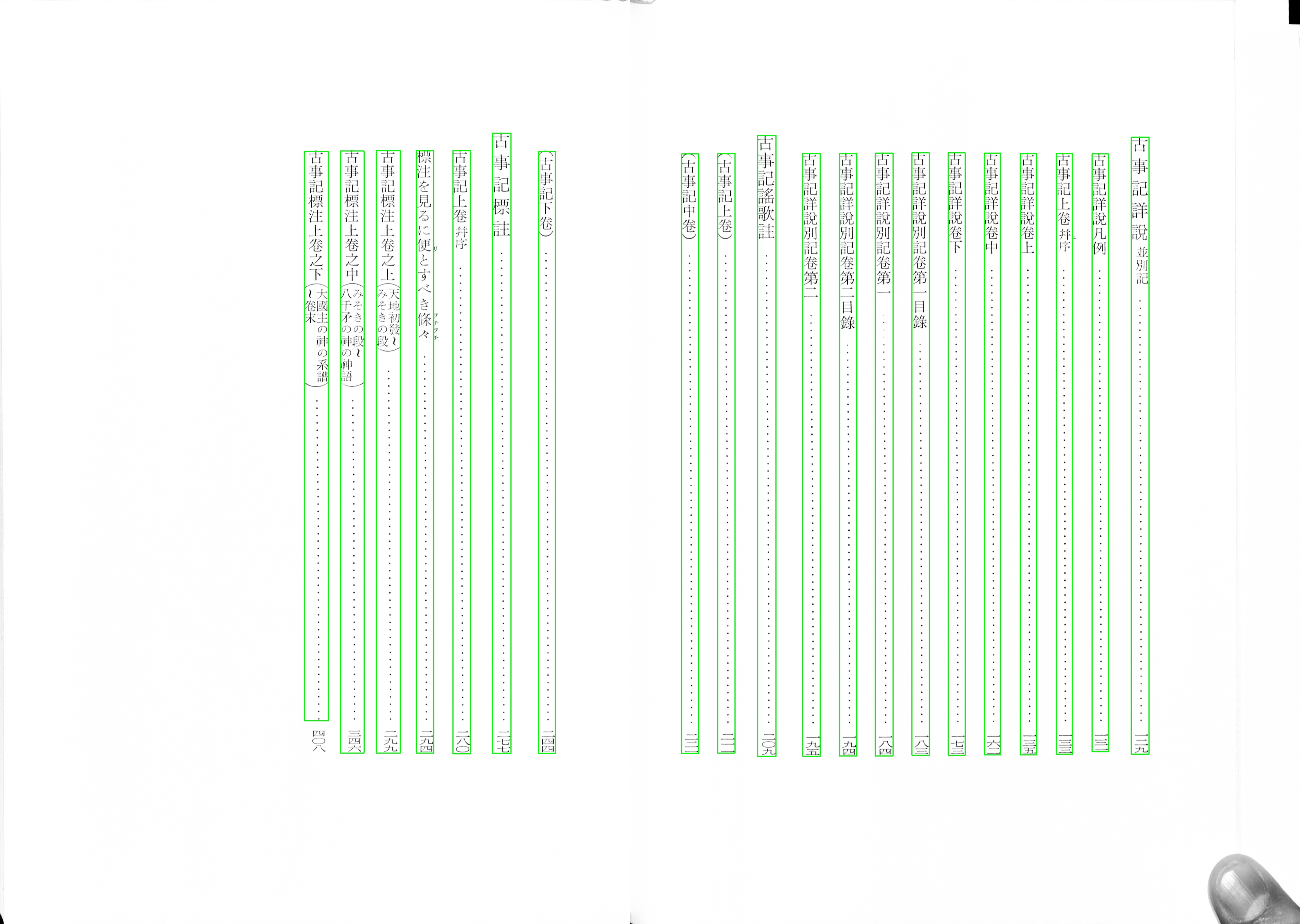

3. Datenset

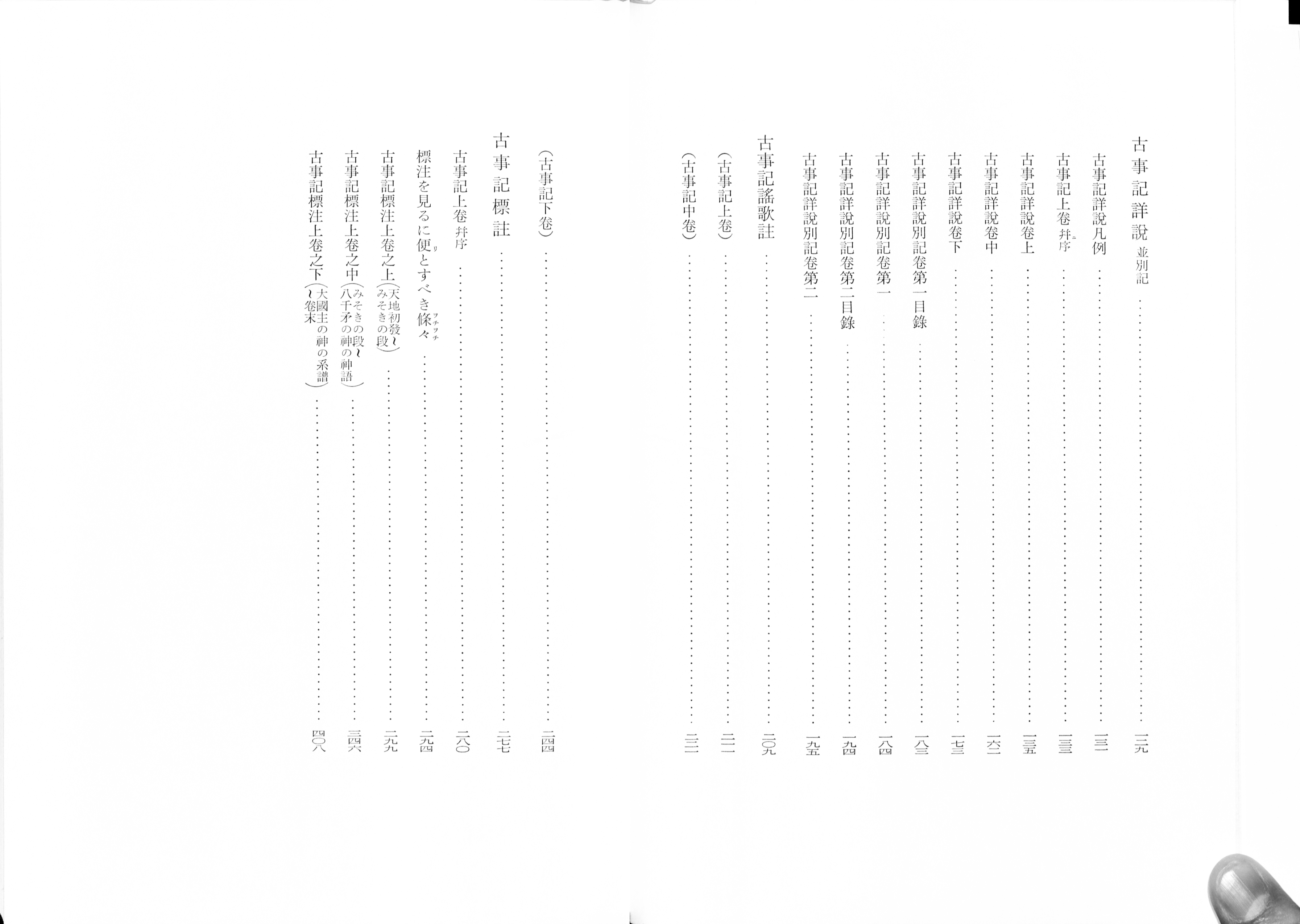

Zuerst Textbereich markieren...

Danach den Aussenbereich mit der weissen Farben füllen